解码AI黑盒:聊天机器人不安的伦理困境及其解决方法

想象一下打开一个语言潘多拉魔盒,里面充满了信息,但也潜藏着危险的潜力。这就是OpenAI的ChatGPT所处的世界,它是一款先进的语言模型,训练自截至2021年互联网上的数据集。在它产生类似于人类的文本的能力背后,隐藏着伦理困境和深远的影响。本文将深入探讨这些挑战,并概述我们如何在这片未经探索的领域中负责任地航行。

ChatGPT,像其他人工智能模型一样,是一把双刃剑。 它的能力可以改革像市场营销、医学教育和科学研究这样的领域,但它们也带来了意想不到的后果。三个主要的陷阱是:

偏见的放大

ChatGPT,由于其训练基于互联网的大量文本数据,存在着强化现有偏见的风险,因此可能导致歧视性的结果。

谣言传播

能够创建类似人类的文本意味着它可能无意中产生具有误导性的信息或被操纵以制造欺骗性内容。

滥用的潜力

有一个 ChatGPT 的黑暗面,可以被利用来生成垃圾邮件、深度伪造内容或从事其他有害活动。

证据就在布丁里:支持这些难题的证据

那么,这些担忧有多少道理呢?让我们仔细看看证据。

偏见

像孩子一样,人工智能模型也从他们的环境中学习。由于文本数据中偏见的普遍存在,像ChatGPT这样的人工智能系统面临吸收和延续这些偏见的风险。

错误信息

人工智能模型创造具有说服力但具有误导性的信息的能力可能会被武器化以传播虚假叙述,在我们的数字社会中造成混乱。

误用

人工智能模型可能被滥用,创建有害内容,操纵公众舆论,甚至促进网络攻击,将个人和组织数据置于风险之中。

伦理洞见:应用古代的智慧

当尘埃落定时,我们面临一个重要问题:我们如何确保ChatGPT的发展和使用遵守道德指南?为了解决这个问题,让我们求助于哲学伦理理论的智慧:

黄金法则

它强调了待人处事要像对待自己一样重要的原则。这一原则促使开发人员创建尊重用户价值观、公平性和安全性的AI模型。

康德的绝对命令

它提出,如果行动可以在没有矛盾的情况下普遍应用,那么它们在道德上是正确的。开发人员必须考虑ChatGPT的潜在负面影响是否能与这个原则相协调。

功利主义

它主张为最大数量的人带来最大的幸福。这个视角要求我们在AI语言模型的潜在好处和偏见、错误信息和误用等潜在风险之间取得平衡。

走出迷宫:道德建议

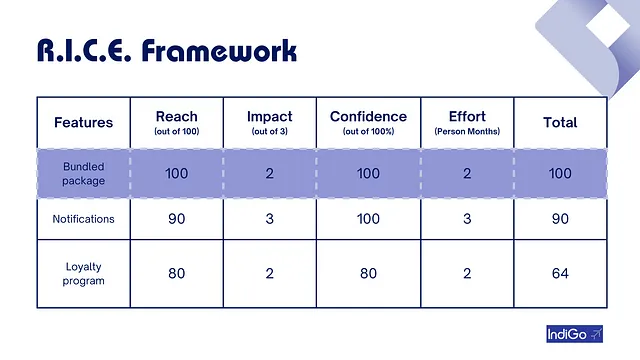

那么,我们如何确保人工智能的发展不会践踏我们的道德伦理?这需要一个综合的方法,平衡严格的指南、创新的解决方案和积极的参与。

1. 制定强有力的人工智能伦理准则:这包括促进人工智能系统的透明度,力求公平避免刻板印象或歧视,并建立清晰的责任界限。

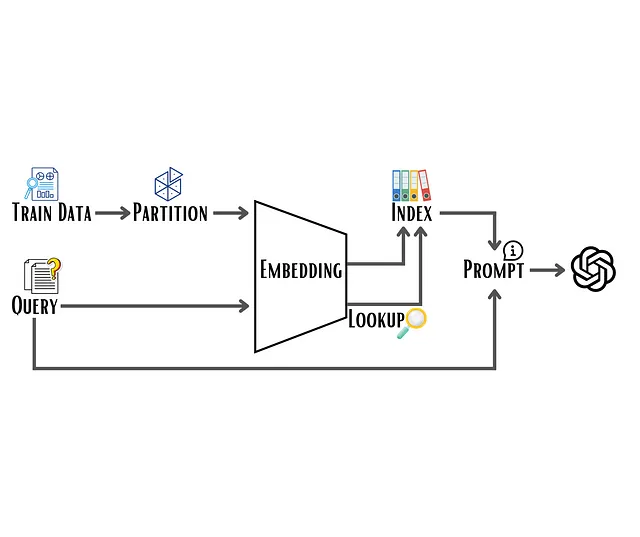

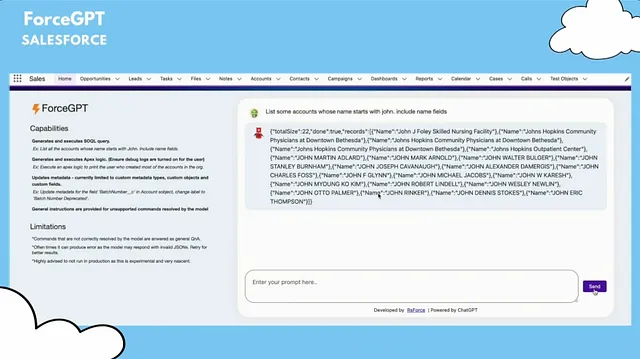

2. 实施技术解决方案:减少偏见和错误信息需要开发偏见缓解技术、错误信息检测机制和输出过滤方法。

3. 与利益相关者合作:这包括与外部研究人员合作、寻求公众意见以及与政策制定者合作,制定促进道德人工智能发展的规定和指南,包括用户、研究人员和政策制定者。

这次订婚应该包括:

协作研究

与外部研究人员、组织和伦理专家合作,不断改进人工智能系统并解决伦理问题。鼓励多元化的观点,可以帮助识别潜在的盲点,并确保更负责任的人工智能发展。

公众反馈

通过公开论坛、调查和其他渠道征求公众对人工智能发展、部署和监管的意见。公众参与可以帮助确保人工智能系统与社会价值观保持一致,解决与公平、透明度和责任相关的问题。

政策制定

与政策制定者合作,制定促进AI系统道德发展、部署和使用的规定和指南。包括制定行业标准、建立监管机构和鼓励采用最佳实践。

结论

AI(人工智能)如ChatGPT所涉及的伦理困境是复杂的,需要深思熟虑的透彻分析。本文通过不同的伦理视角,审视了这些困境,并指出了AI语言模型可能带来的负面后果,例如偏见、错误信息和滥用等问题。

通过实施一个全面的方法,包括健全的AI伦理准则、技术解决方案和积极的利益相关者参与,我们可以减轻像ChatGPT这样与AI相关的伦理关注。开发人员、用户、研究人员和决策者之间的协作是解决这些挑战并确保AI系统与社会价值和期望相符的关键。

在负责任的AI开发和使用方面进行持续对话是利用ChatGPT等AI语言模型潜在利益的关键,同时最小化可能的伤害。通过不断重新评估我们对AI伦理的处理方式并积极应对新兴问题,我们可以促进发展有助于人类福利和对社会产生积极影响的AI系统。