“真实”的AI风险——无需恐慌煽动

“人类”在处理人工智能的真正风险方面发挥了重要作用,而且将继续发挥作用。

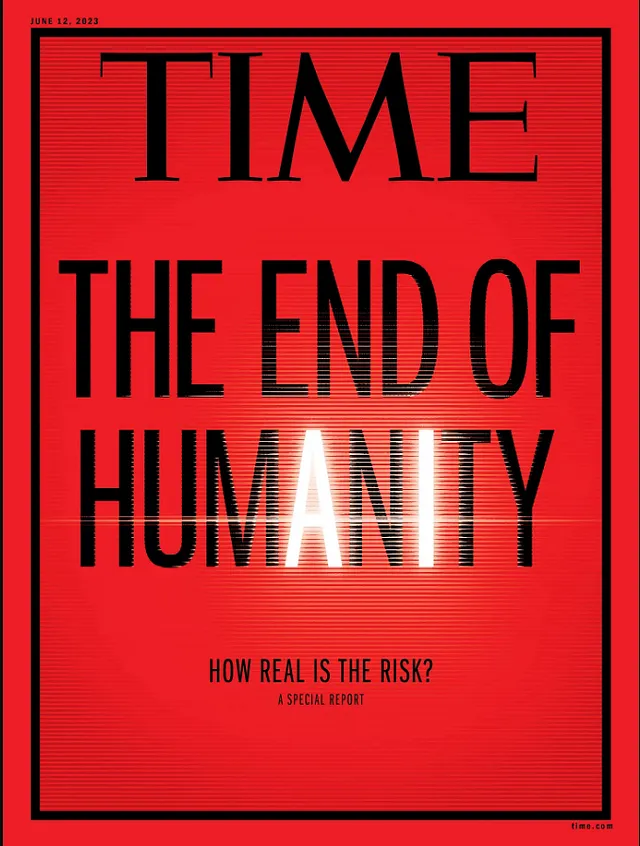

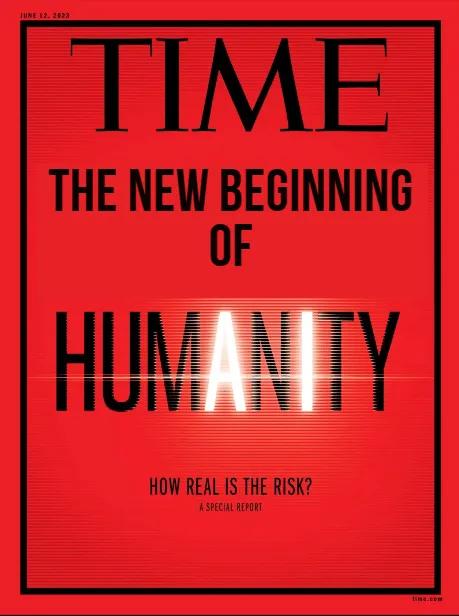

以下图片是《时代杂志》关于人工智能的封面。据报道,封面宣称人工智能可能是“人类终结”的源头,用黑色标注了“人类”一词中的“A”和“I”。

插图的主题基于围绕人工智能的潜在风险。文章主要内容包括人工智能的风险、人工智能竞赛可能的结局等。

杂志在社交媒体上,如Twitter上引发了无数批评。许多网民指出,这纯粹是为了引起注意,称其为灾难性的举动。

虽然我不认为AI会很快就终结人类,但有一件事关于这个问题是很清楚的——我们应该认真考虑风险的真实程度。AI目前需要一个全球监管机构——就像Gary Marcus教授所说的AI的CERN——来解决和应对在快速发展的AI时代中出现的风险。

当前真正的风险不是生存风险。

AI的威胁(尽管不太可能构成生存威胁)目前以其最直观的形式存在。您可以亲眼看到它。花点时间尝试使用生成式AI工具,例如ChatGPT,向其提出有争议或捏造的问题,并观察它如何回应。

GPT-4,最新且很可能是最大的 LLM 模型之一,仍存在误传和幻觉的问题——更不用说这些机器仍然在回答中存在偏见。

第一次使用ChatGPT时,尝试几次似乎并不会造成伤害。ChatGPT作为聊天机器人,只是以一种令人印象深刻的方式给出文本输出。然后自然而然地会问——它如何可能对人类构成威胁呢?

花足够的时间来试用 ChatGPT,你会看到一些不顺利的地方。在花费了相当长时间后,你会开始注意到一些缺陷。

像 ChatGPT 这样的工具常见的问题是在提供回答时产生幻觉、误导和偏见。

幻觉是指一种现象,即AI系统自己编造事实——因为它们缺乏推理。

另一方面,偏见是包含偏见的不准确响应。它通常是由于AI系统所训练的训练数据质量不佳而引起的。

出于幻觉和偏见,解决偏见相当困难。对于人类来说,偏见是一个棘手的问题。

虽然通过将其与现有数据进行比较可以检测到错误信息和幻觉,但是您如何验证偏见呢?

当然,您可以进行同行评审和手动标准测试,以确定陈述是否存在偏见。但是,如何将这种偏见识别编码到算法中,以便大部分时间都保持一致呢?

那相当困难。

但如果我们真正想要开发一个安全的AI系统,实现这个里程碑非常重要。需要有一个明确定义的机制来满足安全和法规要求。

无论我们在处理什么事情,有一件事是至关重要的-即需要人类干预。

人类需要人工智能,而好的人工智能也需要人类。

在机器学习中,我们有一个叫做 RLHF 的机制,通过始终收集人类反馈来优化 AI 模型。这是一种成功的方法,可以通过 ChatGPT 等工具来微调响应。

相当讽刺的是,人工智能要成为一台假想的代替人类的机器确实需要人类。人类制造这些LLM,并对其进行微调,推动AI的发展。何时才能让AI变得“聪明”?当它产生我们所需的结果,以满足我们的需求,即同时可靠且快速。因此,人类对于这些机器的长期可持续性和使AI安全变得至关重要。

虽然AI的未来不会出现终结者的情景,但它仍然是危险的。

拥有巨大权力的不良玩家可以使用人工智能来造成不和谐。无论是可能引发暴力的人工智能生成的图像,还是意外向这些庞大的数据挖掘机泄露您的信息,这些情况都可能会造成伤害-无论是直接还是间接的。

忘记机器。即使是人类使用的错误信息和偏见沟通也足以导致不和谐。人工智能机器使得散布错误信息变得更加高效,从而引起了不和谐。

即使错误信息、幻觉和偏见不在您的头号危害清单上,那么还有一个因素您也应该考虑——人工智能竞赛。

企业和公司竞相赶上人工智能的发展。

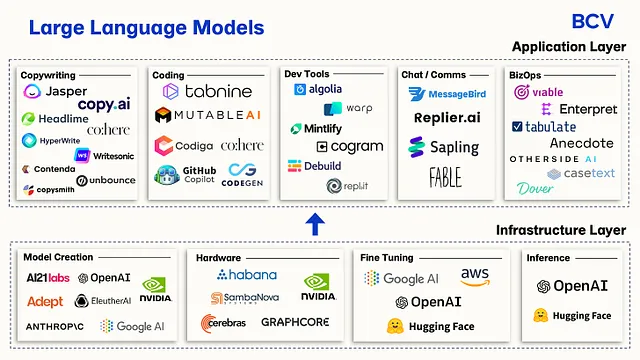

企业似乎越来越依赖人工智能。或许有点过分了。仅仅今年,我们就见证了众多人工智能创业公司的出现。

个人而言,我仍然犹豫是否称呼它们为人工智能初创公司 - 因为其中许多公司仅仅使用像OpenAI或HuggingFace之类的API。它们中的大多数并没有开发自己的人工智能系统。

但我觉得那很好。他们的系统有人工智能组件,从那个角度来看,它确实为“AI驱动”标签提供了正义。

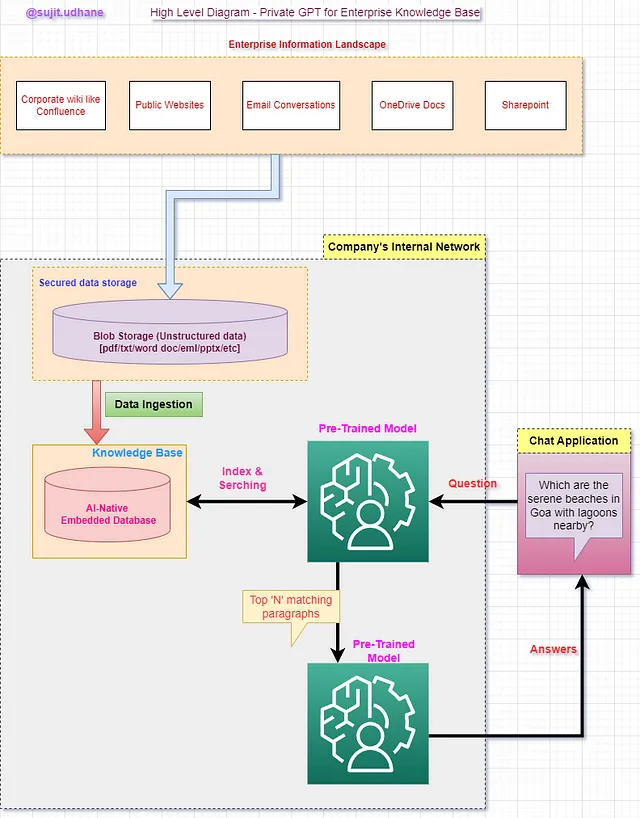

上面的图片展示了不同AI应用程序增强生态系统的一个良好的示例。生成式AI被期望成为AI的子领域,如果有可能的话,将被转换为AGI。

在理论上,这是令人担忧的,因为这是同样威胁到就业的AI领域。每当我们谈论到AI取代人类时,很有可能是涉及生成式AI。

但是,在这种情况下获得最大收益的是从这些人工智能系统中获得巨额利润的企业。

虽然我提到在商业生态系统中,完全依赖人工智能可能不可靠,但是人工智能已经开始对工作产生影响。

尽管这样忙碌,我并没有看到一个AI可以独立地提供所需的结果的例子。要使AI在您的主要工作中发挥作用,必须有人进行事实检查或评估结果。原因是一样的——错误信息和幻觉。

一个著名的例子是 BuzzFeed,讽刺的是。BuzzFeed今年早些时候表示将使用人工智能来帮助更快地创建内容。而CNET则发现,在使用人工智能编写内容时,其超过一半的人工智能撰写的文章存在错误。

具有讽刺意味的是,你使用人工智能制作内容越快,整体速度反而越慢 - 因为你现在必须手动进行事实核查。

到了严格规定和社会安全保障人工智能的时候了。

人工智能独自存在,因此长期来说无法发挥其功效。必须要有人类在场 - 来验证和优化人工智能系统 - 才能获得所需的结果。

如果AI能够独立工作(也就是说,如果实现了AGI),AI会首先取代CEO。你不这么认为吗?

《时代》文章还提到了以下几句话(由我强调),这深刻地 resonated 随着企业之间 AI 竞赛的可能结果。

值得注意的是,在经典的军备竞赛中,一方理论上总是可以领先并获胜。但在人工智能领域,胜利者可能是先进的人工智能本身。这可能会使“(人工智能的)匆忙发展”成为失败的举动。

这也符合人工智能系统的民主方面。正如Sam Altman在这篇文章中强调的那样 - 必须有一种机制,确保普通人在人工智能系统的发展中有发言权。

并且,为此,人们必须接受教育,了解我们在人工智能方面所解决的问题。

与Web 2.0大爆炸时一样,网络钓鱼活动也受到了关注。网络钓鱼活动给用户带来了巨大的损失,90%的数据泄露都是由网络钓鱼引起的。这在很大程度上要归咎于用户自己。

但是在Web 2.0两个十年之后,人们现在意识到网络钓鱼的企图,并学会了谨慎。

以类似的方式,人工智能安全应该从人开始。

真正的风险应该为众所周知。

如果这是可能的,我们可以希望杂志有一种备选封面。

你对跟上最新的技术和人工智能进展感兴趣吗?

那么您肯定不想错过我的 Substack 免费每周简报。我会在简报中分享关于技术、人工智能和科学的见解、新闻和分析。