用热情、目的和价值观设计ChatGPT。

ChatGPT的崛起让很多人感到惊讶,包括人工智能专家。不仅是聊天程序本身令人惊讶的能力,还有大众在很短的时间内对其进行了大规模的适应。从未有过如此迅速的IT创新。但是,这种技术适应似乎带来了一些严重的道德后果。我们该如何应对呢?

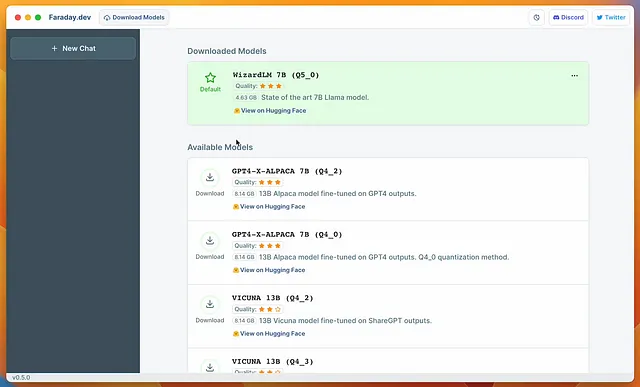

许多机构正在研究如何应用OpenAI的ChatGPT、Google Bart、Microsoft Bing等大型语言模型(LLM)。不仅为自己,也为他们的客户和顾客。在Capgemini,一个充满热情的全球社区已经形成,探索ChatGPT的可能性。这包括为我们的客户寻找商业用例。最大的问题是:ChatGPT如何增加我们客户的效率和盈利能力?在道德边界内。就像Capgemini在其AI道德准则中设定的一样。到目前为止,一切顺利。

然而,我们也看到出现了一些可疑的用例。例如使用大型语言模型制造假新闻照片,进行网络钓鱼和新闻攻击。除了恶意用途之外,我们还看到其他问题出现。这不是出于故意,而是过于依赖技术。ChatGPT可能会给出错误答案,但如果用户无法评估这些答案的可信度,用户可能会认为这些答案是真实的。ChatGPT不是一个策划的知识系统,但它包含了隐含的知识。因此,我们将其作为一种知识来源。"Chat GPT不是这样工作的。当涉及到硬性事实时,它是糟糕的。" Burkhard Hilchenbach写道。

“也许ChatGPT及其基础技术更多地涉及超级胡扯而不是有说服力的写作。胡说八道者会以不良动机玩弄真相——为了逃避责任。“(Ian Bogost,《大西洋月刊》)

那我们该怎么办呢?我们将怪兽关起来。我们在已经开始构建系统的时候,使用一份检查清单来评估 AI 应用的伦理。当 ChatGPT 已经在全球范围内全力使用时,我们讨论隐私和版权问题。当事情出了问题时,我们安装护栏来避免最严重的失误。我们使用过滤器来过滤掉胡言乱语、虚构的内容。(为什么会有虚构内容呢?)"ChatGPT 的内容过滤器旨在确保这个 AI 工具的安全使用。这些内容过滤器有助于确保 ChatGPT 不会生成任何可能会引起冒犯、不适当或以任何方式有害的内容。” Shaheen Banu 写道。但她也写到这些过滤器如何被规避。这些护栏只提供有限的保护。当一个 AI 开始以我们没有预见的方式行事时,这些护栏将无法保护我们。

让我用一个简单的类比来解释:在荷兰,摩托车的速度限制为每小时45公里。监管机构出于道路安全考虑规定了这个限制。电子限速器被安装以阻止超速。这将防止你超过法定速度限制。但这些限速器可以被规避或出现故障。它们不是完全可靠的。

同样适用于生成式AI,例如ChatGPT和其他AI。过滤器并不是绝对安全的。它们可以被故意绕过,但它们也可能“故障”,也就是无法检测到未预料的和错误的结果或情况。

设计伦理学

回到我们的踏板车。荷兰的立法者为解决超过限速限制的问题做了什么?他们对制造商实行了规定,即踏板车的构造不允许超速。踏板车的传动系统应该设计成这样,即不可能超速。通过设计,因此根本不需要限制速度。

技术必须被设计成这样一个方式,即在第一时间不会出现关键情况,这也包括困难情形,即自动驾驶汽车面临“决策”,应该实施两种无法相互权衡的损害之一的情况。

史蒂夫·琼斯写道,最好的事情是,“人工智能无法超越其边界工作,也无法制造虚假答案。” 使用这种设计原则将大大防止人工智能系统的故意或无意的误用。它能阻止所有误用和滥用吗?那将是一颗难啃的硬骨头。

这是以设计为基础的伦理核心。我们设计和构建我们的系统,以使伦理违规不可能发生,或者事故风险最小化。道路安全价值和人工智能结果可信度的价值是一样的。如果我们想将社会价值融入我们的人工智能中,仅后来加入伦理是不够的。在这种情况下,我们将不得不通过添加不可靠的过滤器和其他措施来修补人工智能系统。我们通过将野兽关入笼子并希望笼子能够承受来驯服怪物。但是,我们为什么要先创造一个可能失控的人工智能系统呢?就像现代版的弗兰肯斯坦怪物一样?

价值观和目的是起点

作为一名设计师,我总是把设计项目的出发点放在物品、实体产品、软件系统甚至组织结构的目的上。每个物品都应该为个人、团体甚至整个社会提供服务。这个目的应该有附加值,可以是量化的,如赚更多的钱,也可以是质量上的,如改善生活条件或创造公正的社会。AI系统也必须有服务目的,但这个目的应该是符合伦理的。为了将伦理价值放在系统的核心位置,人们创造了“伦理设计”、“使用伦理”或“价值驱动设计”等方法。系统不仅应该避免侵犯价值,而且应该增强价值或实现价值。

“正义要求我们不仅考虑利润或绩效,而更要考虑目的。”(安妮特·齐默曼,《波士顿评论》)

在工程领域,故障安全设计是一种价值观。工程师构建系统,从踏板摩托车到核电站,这些系统都不能违反道德准则或法律法规。或者至少,为避免失败而采用了所有可想到的方法。但奇怪的是,在软件工程中却未采用这种范式。我们是在建造像切尔诺贝利核电站一样的人工智能吗?等待人为或意外的错误发生。

我的坚定信念是,如果人工智能被设计得好,即便被用于不道德的目的,仍然可以变得道德。但是,如果人工智能被设计得不好,几乎总是不道德的。

“让世界变得更美好:用激情、追求和价值观设计”是由Robert Kozma博士制作的一个视频的标题。这个标题包含了所有的内容。如果我们希望像ChatGPT一样的人工智能能够行为符合伦理道德,我们需要创建适合目的的人工智能算法。人工智能应用的目的和目标应该引导选择正确的算法。因此,在应用目的和伦理的背景下,人工智能不能超越我们设定的界限。这是设计时我们的热情。当我们使用ChatGPT和其他大型语言模型时,这应该是我们的热情。

照片公共域CC0通过荷兰国家档案馆/维基共享资源。