利马:用大型语言模型展示监督微调的威力

简而言之:

大语言模型(LLMs)在不断发展,受到ChatGPT等创新的推动。通过人类反馈的强化学习(RLHF)在将LLMs与人类偏好相一致方面发挥了至关重要的作用。RLHF和Supervised Fine Tuning(SFT)是优化LLMs的互补方法。OpenAI的InstructGPT展示了RLHF和SFT成功的结合。RLHF使LLMs更易于控制和有趣,而不会引入新的信息。LIMA是一款功能强大的LLaMa语言模型,使用有监督的损失进行微调,展示出出色的性能和适应性。在受控人类研究中,LIMA的响应与GPT-4、Bard和DaVinci003旗鼓相当甚至更好。

主要人工智能新闻:

持续不断的进步和广泛采用ChatGPT已经使NLP系统达到了前所未有的高峰。在ChatGPT的核心是大型语言模型(LLMs),它们不断进行改进和突破,每天都会发布新的模型。随着越来越多的模型和研究论文被发布,跟上步伐变得具有挑战性。在这个独家博客系列中,我们旨在探讨和深入了解一些迅速扩展的LLM领域中的迷人研究论文。今天,让我们探索Meta最近推出的引人入胜的LLM模型 - LIMA。

大型语言模型的辉煌

大型语言模型通过精心的预训练,在巨大的规模下预测后续标记,使其能够获得适用于任何NLP任务的多功能表示。在ChatGPT的情况下,通过人类反馈引导的强化学习技术(RLHF)实现了这种对齐,这种技术在微调中起着至关重要的作用。然而,关于RLHF的功能及其对LLM行为的影响存在一定程度的误解。Meta关于LIMA的突破性出版物深入探讨了LLM的内部工作原理,提供了宝贵的见解,真正阐明了RLHF的价值。

了解RLHF:揭开神秘面纱

为了有效实施RLHF,我们按以下步骤进行:

- 招募一组人工标注者,对LLM为每个提示生成的多个输出进行评估,并根据他们的喜好进行排名。 - 为确定这些偏好所采用的方法具有重要意义。例如,可以指示标注者将不正确的信息评定为较差,同时鼓励生成有趣的回应。 - 构建一种奖励模型,能够预测每个输出的人类偏好。由于在推断过程中不会有人类评估者可用,因此奖励模型扮演评估者的角色。 - 在称为Proximal Policy Optimization(PPO)的增强学习算法中利用奖励模型对LLM的参数进行微调,从而最大程度地与人类偏好相一致。

RLHF与监督微调(SFT)

RLHF框架作为一种非常通用和统一的方法,能够基于广泛的目标优化LLM。另一方面,监督微调(SFT)涉及通过向LLM提供应复制的对话数据示例来以监督方式微调LLM。这种方法不仅被Google的巴德动力的LaMDA LLM采用,而且还被Meta最近发布的LIMA采用。

动态二人组:RLHF和SFT在InstructGPT中

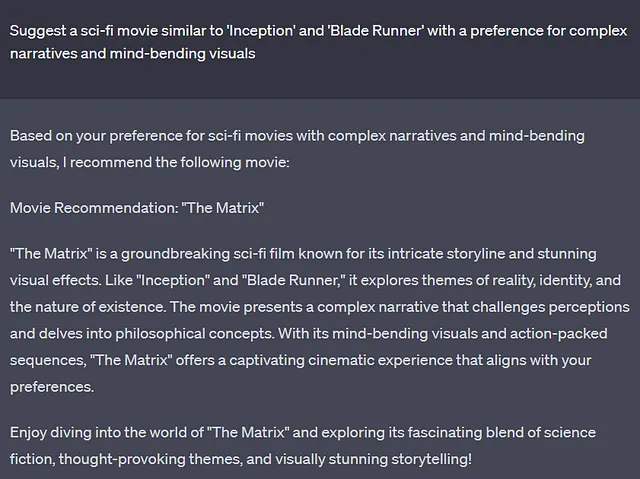

值得注意的是,RLHF和SFT可以共同使用,正如OpenAI的InstructGPT论文所示。 RLHF最初作为InstructGPT的建议方法出现,后来为类似ChatGPT和GPT-4这样更强大的模型的创建铺平了道路。 InstructGPT论文展示了RLHF如何赋予结果LLMs许多理想特性。这些特性包括增加人类评估者的偏好,减少不正确信息的生成,以及增强遵循指示的能力。实际上,RLHF使得通用的预训练LLMs能够转变为我们今天经常遇到的出色的信息寻求对话代理,如ChatGPT。

解码 RLHF 的本质

RLHF的真正本质经常被误解,但最近关注开源LLMs和GPT-4的研究进展提供了急需的清晰度。现在很明显,RLHF主要用于增强LLMs的可控性和吸引力。重要的是,RLHF不会向模型灌输新的知识或信息;大多数知识和信息是在预训练期间学习的。这一事实在openai.com/research/gpt-4上的GPT-4博客文章中明确说明,作者指出RLHF可能会阻碍模型在某些标准化考试上的性能。

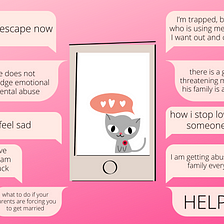

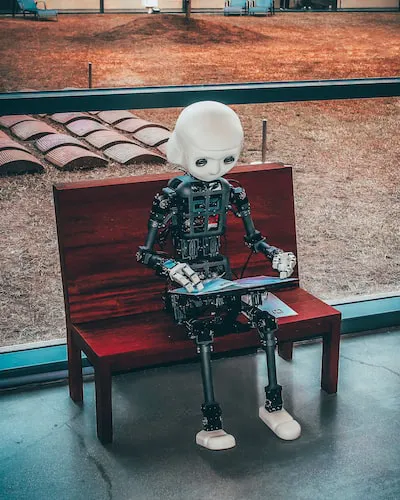

介绍LIMA:赋能Llama语言模型

LIMA是一个拥有650亿个参数的LLaMa语言模型,证明了受监督的微调的巨大威力。它通过在精心策划的一千个提示和对应的回应的标准受监督的损失下进行微调而取得了显著的性能。LIMA的训练过程不涉及强化学习或人类偏好建模。

尽管如此,该模型展示了出色的能力,能够轻松地根据有限数量的训练示例适应特定的响应。它的多功能性扩展到培训数据中未见的新任务。在人类控制的研究中,LIMA在43%的情况下的响应要么等同于GPT-4,要么更受欢迎。与Bard相比,该统计数据达到了令人印象深刻的58%,而与经过人类反馈培训的DaVinci003相比,它飙升至惊人的65%。

LIMA代表了一个重要的里程碑,展示了监督微调的有效性及其产生高度胜任的语言模型超越预期的能力。它在理解和生成复杂查询方面的能力,从行程规划到探索替代历史,突显了LLaMa语言模型的广泛潜力。

结论:

随着有监督的精调和强化学习技术在LLMs中不断取得进步,如LIMA等,这对市场来说是一个重大的里程碑。这些模型提供了增强的功能、改进的性能和生成高质量响应的能力。凭借像LIMA这样的LLMs,企业可以利用自然语言处理推动创新,创建更具吸引力的对话代理人,并探索不断扩大的市场中的各种应用。

欢迎来到翻译示例

以下是英文示例文本:

Translation is the communication of the meaning of a source-language text by means of an equivalent target-language text. The English language draws a terminological distinction (which does not exist in every language) between translating (a written text) and interpreting (oral or signed communication between users of different languages); under this distinction, translation can begin only after the appearance of writing within a language community.

如果您对简体中文翻译感兴趣,请继续阅读。