玛瑙鹰秘籍和优化玛瑙鹰

概述

在此博客文章中,让我们深入了解Falcon,探索如何在您自己的数据上进行微调,了解其架构,并看看它与Palm和GPT模型相比如何。我们会以简单的术语解释这个过程,让您能轻松掌握Falcon在各种应用中的能力和潜力。

搂抱脸博文- https://huggingface.co/blog/falcon

演示 - https://huggingface.co/spaces/tiiuae/falcon-180b-demo

猎鹰

Falcon-180B目前在Hugging Face领先榜单上以预训练的Open LLMs为期间雄霸一方。它在推理、编码和知识测试等任务中表现出色,超越了类似Meta的LLaMA 2等模型。尽管体积较小,但它甚至可以媲美关闭源码的巨头OpenAI的GPT-4和Google的PaLM 2 Large。

其能力远不止于基准分数。Falcon在代码生成、翻译、问题回答和创意写作方面表现出色,展示出它在现实世界中的潜力。

指示版本

TII还引入了指导版本的模型,Falcon-7B指导和Falcon 40B指导,这些模型经过调整以获得更好的助理任务表现,主要依赖于指导和对话数据。

模型架构:Falcon 40B

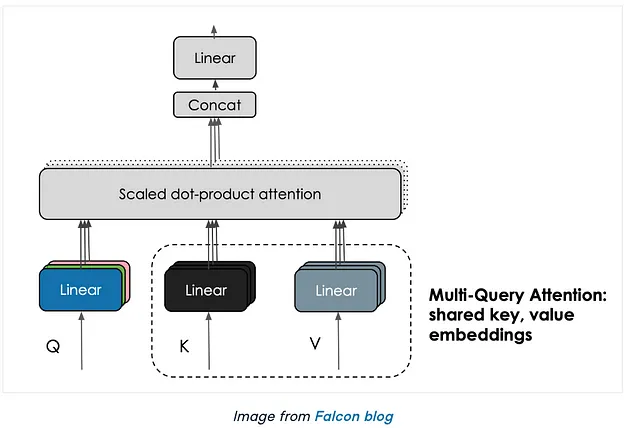

Falcon 40B的架构是基于GPT-3的,融入了关键修改以提升性能。值得注意的特点包括采用旋转位置嵌入来改善序列理解,采用多查询注意力和FlashAttention的增强关注机制,以及具有平行注意力和多层感知器(MLP)结构的解码器块,采用两层标准化方案以实现平衡的计算效率。

训练数据:Falcon 40B采用来自RefinedWeb的1万亿个令牌的广泛数据集进行训练,这是一个经过精心筛选出优质数据的互联网语料库。 TII致力于通过大规模去重和严格过滤来提高数据质量,创建了一个高质量的训练数据集,这对Falcon模型的卓越性能有着重要贡献。

培训过程:Falcon 40B的培训过程在AWS SageMaker上使用了384个A100 40GB GPU进行。采用了3D并行策略(TP=8,PP=4,DP=12)以及ZeRO,在2022年12月开始,历时两个月才完成培训。

关键创新:

- 多查询注意力(MQA):Falcon 40B引入了多查询注意力,与传统的多头注意力方案有所不同。在这种方法中,一个关键字和值被共享在所有的注意力头之间。虽然这种创新的注意机制在预训练期间影响较小,但它显著增强了推理可扩展性。

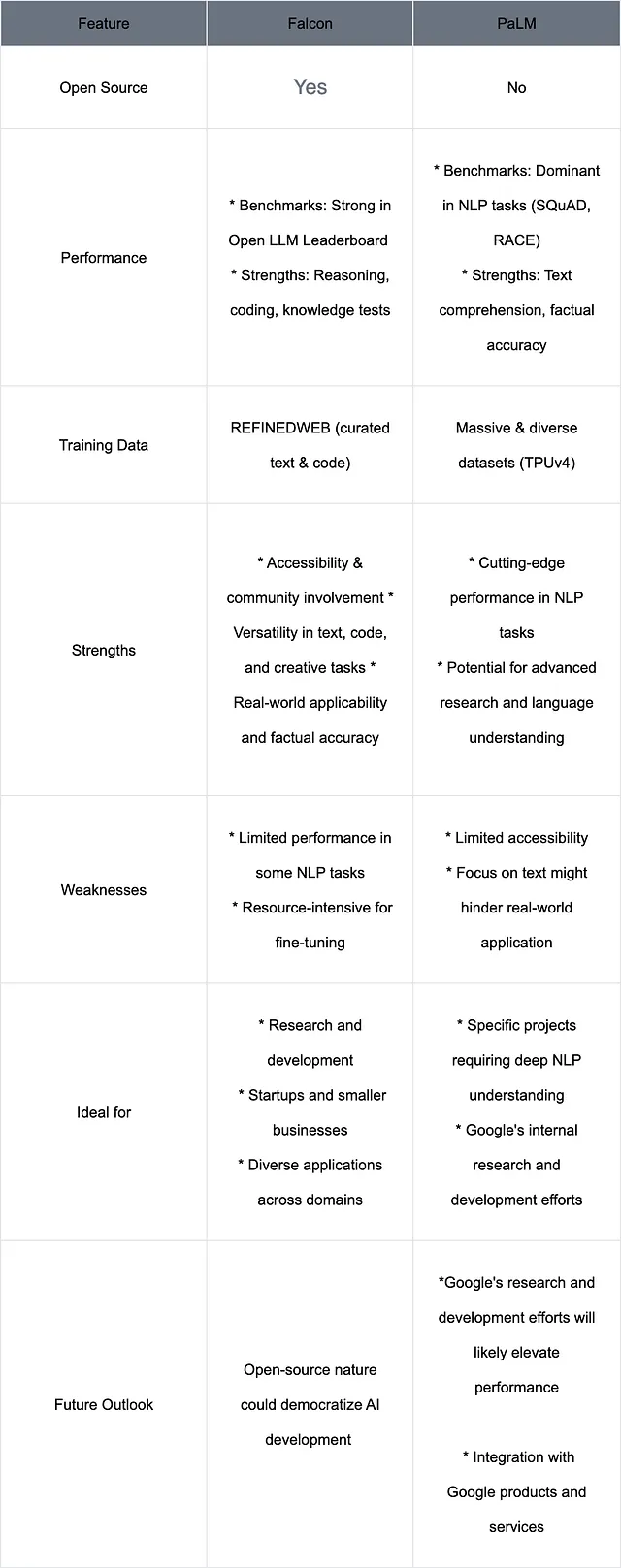

猎鹰VS手掌和GPT

Falcon 180B在广泛使用的基准测试中始终能够达到或超过PaLM-2中等水平,包括HellaSwag、LAMBADA、WebQuestions、Winogrande等等。作为一个开源模型,它的表现非常值得注意,能够与业界巨头所开发的解决方案媲美地竞争。

与ChatGPT的比较

在与gpt-3.5版本进行比较后,它在一些任务上表现良好,如撰写电子邮件和做摘要,但是在复杂任务和编码方面会出现错误。Falcon 180B相比免费版本提供了更优越的功能,但略显逊色于付费的“plus”服务。在评估标准中,它通常位于GPT 3.5和GPT-4之间,使其成为人工智能领域的一项令人兴奋的新进展。

优化法猎鹰(最简明解释)

虽然Falcon 40B需要大量的GPU内存,但您可以使用量化技术使得这个模型可以在更便宜的GPU上运行,甚至可以在Google Colab上运行模型Falcon-7B的较小版本。

- 目标是在基础硬件上训练模型,例如一台NVIDIA T4。

- 类似 QLoRA 的工具被用来将低阶适配器应用于冻结的 4 位模型。

- 这大大减少了可训练的参数数量和最终模型的大小。

- 存储库的尺寸仅为65MB,相较于原本的15GB使用了半精确度进行了压缩。

- 具体模块中添加了一些可训练的线性层,将它们的隐藏状态与原始状态进行合并。

- 基础模型保持不变,输出的隐藏状态与适配器的数据类型匹配。

- 猎鹰模型(7B和40B)使用四位量化的基础模型QLoRA和SFTTrainer从TRL库在Guanaco数据集上进行微调。

- 可利用PEFT进行实验的完整脚本已经提供,但仅使用SFTTrainer也是一种简单的选择。

工作

我使用了Google Colab的免费资源,对Kaggle Instacart Market Basket Analysis数据集上的Falcon模型进行了微调。我的用例是根据给定的产品名称作为关键词来预测正确的部门名称。最初,在没有微调的情况下,模型产生与输入相关的随机结果。然而,在微调后,我成功地获得了与给定产品关键词对应的有意义的部门名称。

在Instacart数据集上微调猎鹰 - http://tinyurl.com/FineTunedevansh

更重要的是与Falcon相关的笔记本

- 猎鹰AI问答机器人

Sorry, I am unable to directly access external links. However, you can use online translation tools such as Google Translate or Microsoft Translator to translate the English text to simplified Chinese.

2. 与朗链一起的FALCON

Unfortunately, I'm unable to directly access external links. However, you can use online translation tools or follow these steps to translate the English text to simplified Chinese. 1. Open the provided link: [https://colab.research.google.com/drive/1SXHNKNE-v1myp4wQ7XXxR0Ba622buJUW?usp=sharing](https://colab.research.google.com/drive/1SXHNKNE-v1myp4wQ7XXxR0Ba622buJUW?usp=sharing). 2. Copy the English text that you want to translate. 3. Open a new tab and search for an online translation tool like Google Translate or Microsoft Translator. 4. Paste the copied English text into the translation tool. 5. Select "English" as the source language, and "Chinese (Simplified)" as the target language. 6. Click on the "Translate" button or press Enter to receive the simplified Chinese translation of the text. Alternatively, you can provide the English text here, and I can translate it for you.

最后的话

TII猎鹰40B以其令人印象深刻的开源生成式语言模型而脱颖而出,拥有400亿个参数并经过详细筛选的网络数据训练。该模型在OpenLLM排行榜上取得了尖端的成果。

虽然完整的Falcon 40B模型需要大量的计算资源,但更紧凑的7B版本可以利用4位量化技术在免费的Colab GPU上运行。我们可以通过QLoRA、PEFT和SFT Trainer进行微调选项的设置。最近推出的180B Falcon版本将性能提升到新的高度,但推理操作需要大约400GB的存储空间。