深入探索大型语言模型:创造力、可靠性和挑战

机器学习学科对于大多数人来说并不陌生,它已经在我们的社会中蔓延了60多年。如果您对整个机器学习还不太熟悉,安德鲁·吴(Andrew Ng)的著名名言非常精辟地概括了机器学习的基本原理和目标。

如果一个计算机程序对一类任务T以及性能度量P在体验E中具有学习能力,那么它在T任务中的表现,以P为衡量标准,会随着体验E的增加而提高。

基本上,机器学习是将统计和计算科学相结合,构建模型以复制或自动化某些任务的学科。无论你的算法变得多么智能,总会有一些异常值。你可以用一些矩阵来跟踪你的模型性能,包括假阳性,假阴性等。

大语言模型是如何工作的?

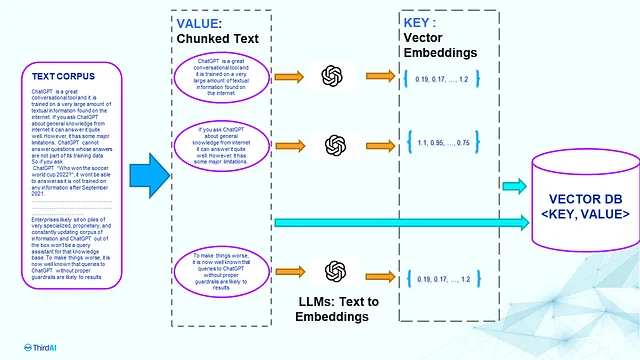

首先,你需要了解ChatGPT是GPT模型(基础模型)的衍生物。一般来说,GPT模型会做一些句子完成,即根据其训练数据,根据你的提示继续。

从许多角度来看,ChatGPT与搜索引擎在技术架构方面有很多相似之处。首先,它们都是基于Transformer的模型,其中你可以创建密集的嵌入来为用户查询创建上下文,以使计算机理解它。其次,目标是其输出应与输入具有语义相似性。

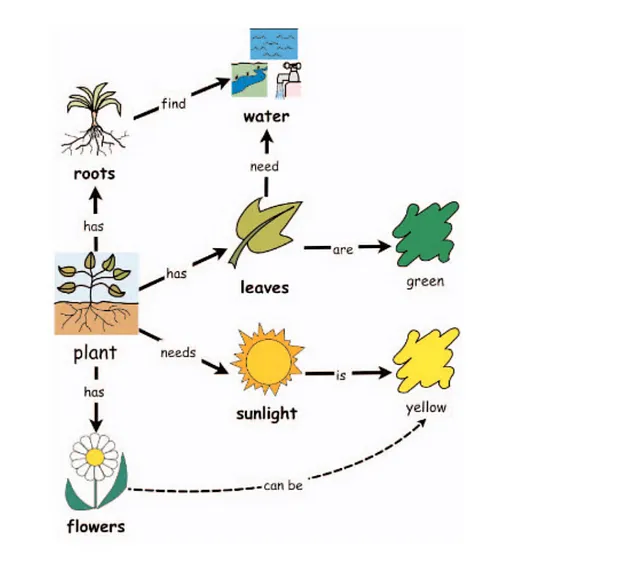

与“搜索引擎返回存储在数据库中的可验证响应”不同,GPT模型具有构造自己的句子而难以验证的能力。简单说,GPT模型将预测您的句子后最可能的单词,并不断迭代。例如,“AI有能力”这样的句子可以根据模型的密集嵌入在条件上下文和其训练数据的构造下,由“学习”、“销毁”和“创造”完成。这种句子构造过程是由神经网络实现的,神经网络是另一个重要组成部分,我将在不久的将来在我的博客中解释。

创造力和幻觉:同一枚硬币的两个面。

与旨在优化准确性的情感分类器不同,ChatGPT 不一定只想优化最高概率,因此它按“温度”控制所有可能候选项中的最高概率中的一个进行随机抽样。如果您总是追求最高排名的单词或句子,那么您会得到一个平淡无奇的文章。相反,ChatGPT 类似的模型确实选择了排名较低的单词,因此它变得有创意、有趣,有时甚至出人意料,尽管目标是要重现人类的回应。就像我们一样,有时候我们都会说和写出一些没有意义的话。

创造力和可靠性的挑战反映了模型本身存在错误的事实。

问题和解决方案

如果只对最高概率进行抽样,这种方法能够解决幻觉吗?它只会减少而不会消除。因此,像任何其他机器学习用例一样,让人类参与其中非常重要。

到目前为止,评估ChatGPT的输出的真实性仍然是一个未解决的问题。很难建立一个矩阵来确定模型是否在进行评估时虚构东西,更不用说这个大语言模型正在处理生活和社会的各个方面的上下文。一些不真实的东西可能在某些其他上下文中是真实的。

一些策略可以使用,例如在向客户提供服务之前缓存和在晚上进行推理,并在人类质量保证之前进行评估。

其他相对比较新颖的想法涉及到是否可以去除人类质量保证层,比如创建多个ChatGPT实例作为调解员和思维树,为逻辑推理提供增强。